自動運転技術とAIの進化が加速する中で、注目を集めている自動運転スタートアップがチューリング株式会社です。2021年8月に創業した同社は、カメラ映像のみを使ったEnd-to-End(E2E)自動運転システムを開発中です。

従来の光による測距技術「LiDAR(ライダー)」や高精度地図に頼らず、カメラ映像をもとにステアリング、アクセル、ブレーキといった運転のすべてをAIが判断する仕組みの実現を目指しています。

その中心にあるのが、完全自動運転を目指すAIモデル「TD-1」。カメラ映像を入力し、周囲の標準解像度地図や車両・歩行者の認識、運転操作までを単一のTransformerモデルで処理する最先端の技術です。

今回は、チューリング株式会社 共同創業者・青木俊介さんにインタビュー。自動運転の未来や、AI技術の可能性について、博報堂メディア環境研究所の冨永直基が伺いました。

生成AIこそが「レベル5=完全自動運転」を現実に

――2024年10月に、チューリングが開発する自動運転AI「TD-1」の走行試験が始まりました。現在はどんな状況ですか?

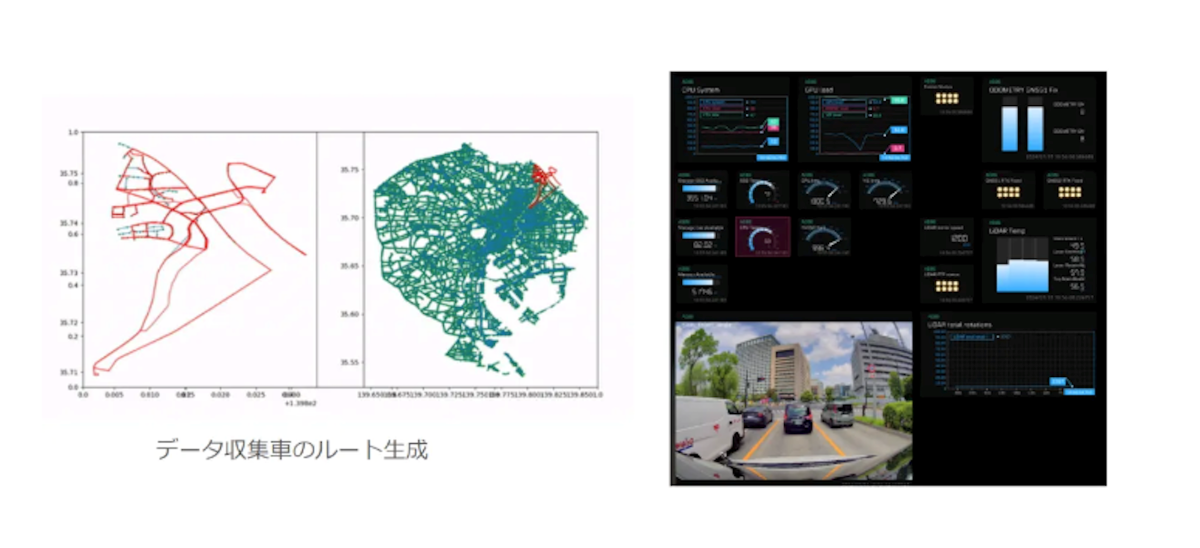

最初はテストコースでしたが、今は街中での試験走行も進めています。データ収集車両は1日に4~10台、テスト車両1~2台が都内全域で走行中です。

ただし、AIがどこまで正しく運転できるか、まだ完全な予測はできません。そのため、プロのテストドライバーがいつでもハンドルを取れる状態で検証を進めています。

――走行時は、どのような技術を使っているのでしょうか? これまでは、カメラとレーザー光を使って周囲の物体までの距離を測定し、3Dマップを生成する技術「LiDAR(ライダー)」を使用するケースもあったと思います。

「LiDAR」はデータ収集時の認識精度チェックに活用していますね。ただ、走行時に使っているのはカメラのみで、基本的にはAIが画像を解析して運転しています。

自動運転には0~5のレベルがあり、数字が小さいほど、人の関与が必要です。この中で、私たちが目指しているのは、一番上のレベル5。呼んだら車が来てどこへでも行ける、AIだけでの完全自動運転です。

従来のレベル4の自動運転は「LiDAR」で作成した地図を頼りに走行するという仕組みでした。でも、地図の作成・更新コストがかかり、街の変化に対応しづらい。ルールベースの自動運転は決められたルールの範囲でしか動けないため、道路工事や突発的な障害物には対応できません。だから、約10年経った今でも商用化が進んでいないんです。

でも、AIなら状況を見て判断することができるのではないか、と考えて。だから、私たちは「エンドツーエンドAI(※)」に完全にシフトすると決めたんです。最初の試作では、カメラ1台と小さなニューラルネットワークで、前方の画像をもとにハンドルやアクセルを操作するシステムを作りました。

(※)人工知能(AI)にデータの入力から出力までのすべてのプロセスを、単一の機械学習モデルに委ねるアプローチのこと。「E2E AI」とも呼ばれる。

創業当時は「AIだけで運転?」という反応も多かったですね。ですが、ちょうど将棋や囲碁でAIが人間に勝ちはじめ、「運転もAIでいけるのでは?」という議論が少しずつ出ていました。

――現在、AIによる自動運転技術はどこまで進んでいるのでしょうか?

自動運転AIも、文章や画像の生成AIと同じように進化しています。「ChatGPT」が言語を扱えるように、自動運転AIも画像解析だけで運転できる時代になりつつあるんです。例えば、AIが映像を見て「この交差点は交通量が多いので。作業員の指示に従ってください」といった運転アドバイスを文章で説明できるようになっています。

また、従来のシミュレーターでは、車と車、車と人のリアルなインタラクションを正確に再現できませんでした。例えば、ゲームではキャラクター同士がぶつかると動けなくなることがありますが、現実の車はそうはできないですよね。

そこで、AIが映像データをもとに未来を予測する自動運転向け「生成的世界モデル・Terra」を開発しました。

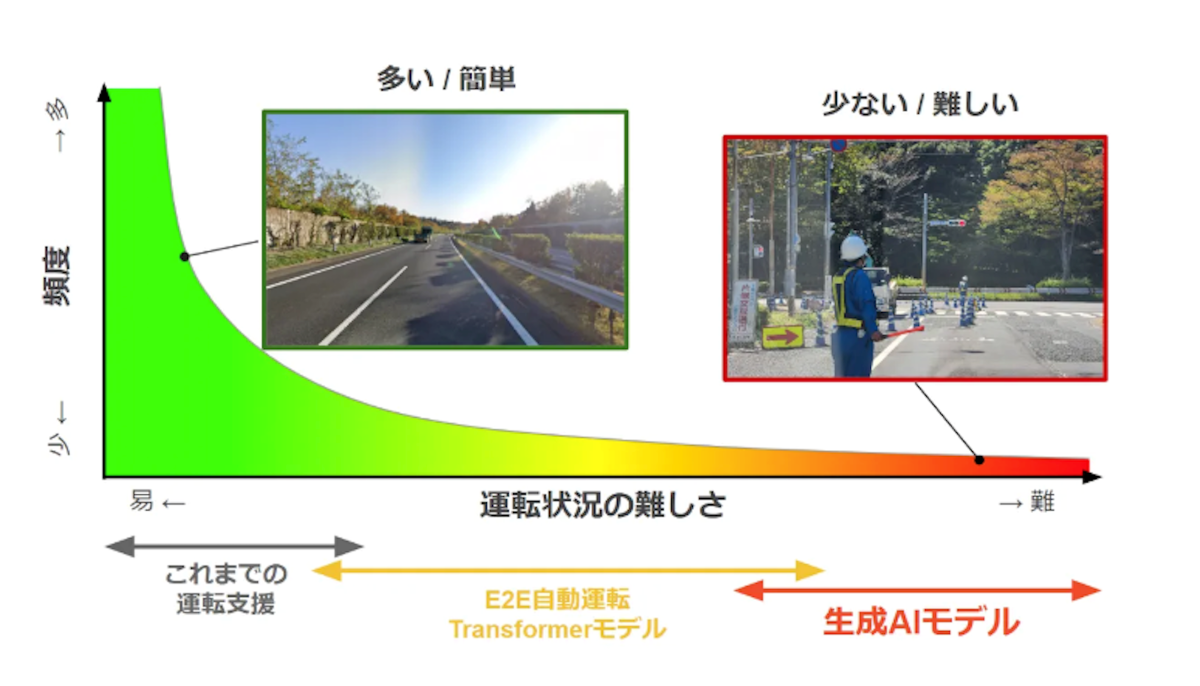

運転も、いわゆるロングテール現象が起こるんですよね。つまり、白線があるだけのシンプルな道のような「よくある運転パターン」の予測は簡単。

でも、信号や交通誘導員がいる工事現場などの「たまに発生する複雑なシチュエーション」がすごく難しい。これがルールベースの自動運転だと突破できないんですよ。ですが、AIが「次に何が起こるか?」を予測すれば、より人間に近い運転判断ができるようになります。

また、AIが人間の運転の意図をデータ化することも重要です。そこで、「この歩行者がこっちを見ていなかったから減速したんだ」など、意思決定のデータを蓄積し、AIの判断力を向上させています。